Wie funktioniert Künstliche Intelligenz als Assistent und Wahrnehmungserweiterung?

Der Schlüssel zur Nutzung von Künstlicher Intelligenz ist ein Terzett aus Datenkompetenz, Integrations- und Verwertungsstrategie. Unsere Themenseite begleitet Sie in diese Welt und zeigt Ihnen, warum Künstliche Intelligenz sowohl ein Werkzeugkasten als auch eine eigene (neue) Denkweise ist.

Schnelleinstieg für AI-Newbies:

- Was ist Künstliche Intelligenz?

- Was unterscheidet Künstliche Intelligenz und Bewusstsein?

- Welche Vorteile hat Künstlicher Intelligenz?

- Wie funktioniert Künstliche Intelligenz?

- Was ist eine schwache Künstliche Intelligenz?

- Was ist eine starke Künstliche Intelligenz?

- Was sind die Grenzen Künstlicher Intelligenz?

Erhalten Sie neue Insights aus Ihrem Online-Business.

Jetzt Termin vereinbaren und Datenpotential Ihres Online-Business entlang der gesamten E-Commerce-Wertschöpfung entdecken.

Die Definition von KI: Was ist Künstliche Intelligenz?

Artificial Intelligence (EN) / Künstliche Intelligenz (DE) verbindet die Fachbereiche Statistik und Informatik. Das Ziel Künstlicher Intelligenz ist es, dynamische Datenströme automatisch zu verarbeiten und im Bruchteil von Sekunden valide, datengetriebene Entscheidungen zu treffen. Die treibende Kraft hinter der Entwicklung Künstlicher Intelligenz ist die Abbildung von Informationserfassung, -verarbeitung und -bewertung in Algorithmen und Software. Sie beginnt mit der Formulierung des berühmten Turing-Test.

Alan Turing skizzierte 1950 seine Idee, wie festzustellen wäre, ob ein Computer ein dem Menschen gleichwertiges Denkvermögen hat. Dazu führt eine Person eine Unterhaltung mit einem anderem Menschen und einer Maschine. Er weiß jedoch nicht, welcher seiner Gesprächspartner der Computer ist. Wenn der Mensch die Maschine nicht korrekt enttarnen kann, kann dem Computer ein humanoides Denken zugesprochen werden. Problematisch an diesem Experiment ist, dass der Turing-Test lediglich eine funktionale Interaktion prüft, nicht aber die Intention der Maschine.

Heute nutzen Unternehmen Technologien und Softwarelösungen, die Informationsverarbeitung optimieren. Künstliche Intelligenz-Anwendungen sind beispielsweise in der Lage, in Echtzeit das Optimum aus Kosten, Zeit und Qualität im Produktionsprozess zu ermitteln und dabei gleichzeitig auf Störungen im Ablauf zu reagieren. Das macht KI effizienter und effektiver im Vergleich zu den meisten menschlichen Kollegen. Künstliche Intelligenz integriert Datensilos und Dark Data, nutzt Big Data Analytics und speist Tools, die repetitive Aufgaben intelligent übernehmen.

Künstliche Intelligenz und Bewusstsein

Künstliche Intelligenz ist sich seiner Intelligenz nicht bewusst. Sie ist ein Werkzeugkasten, der Unternehmen und Branchen verändern wird. Sie arbeitet mit mathematischer Präzision. 24 / 7. Ohne Urlaub oder Krankheit.

Wer sich heute für KI begeistert, sollte Marvin Minskys Paper aus dem Jahr 1960 lesen. Darin beschreibt er deutlich, dass Künstliche Intelligenz nur Muster erkennen und verarbeiten kann, die es gelernt hat. KI weiß nicht wie und was sich hinter dem Dateninput, den Zeitreihen oder Vektoren verbirgt. Sie ist kein Mensch. Sie kennt nur den Kontext, der sich aus den Input-Daten ergibt. Künstliche Intelligenz verarbeitet große, dynamische Datenmengen. Bei der richtigen Umsetzung unvoreingenommen und blitzschnell.

Künstliche Intelligenz ist also eigentlich eine irreführende Bezeichnung, denn KI hat viel mehr mit explorativer Datenanalyse, Software- und Informationsarchitekturen gemeinsam als mit Intelligenz i.S.v Kognition und bewusster Wahrnehmung. Wer Künstliche Intelligenz trainiert, versucht einer Maschine Intuition und Bauchgefühl näher zu bringen.

Was sind die Vorteile von Künstlicher Intelligenz?

die bestehenden Daten bereits derart reich an verborgenen Geschichten und Erkenntnissen, dass eine Konzentration auf die eigene Datenautonomie effizienter ist, als eine Verwässerung mit Third-Party-Data unbekannter Qualität.

Künstliche Intelligenz und Intelligent Empowerment

Im Zusammenhang mit KI-Software fällt immer häufiger der Begriff Intelligent Empowerment. D.h. mit KI-Tools werden Menschen effizienter und ihre Entscheidungen werden effektiver. Künstliche Intelligenz ist ein Toolset, in dem sich verschiedene Disziplinen treffen. Es bietet neue Perspektiven um Geschäftsprozesse zu analysieren, zu verstehen und zu optimieren.

Diese neue Brille / Denkweise muss zunächst an den unterschiedlichsten Positionen in einem Unternehmen eingeübt werden. Aus diesem Grund kann Künstliche Intelligenz nicht einfach mit der Gießkanne über Ihre Geschäftprozesse verteilt werden.

Die optimale Integrationsstrategie ist kooperativ und stellt Künstliche Intelligenz als Assistenz an die Seite Ihrer Mitarbeiter. Damit wird es möglich Datenqualität, Wertschöpfung und KPIs gleichermaßen zu balancieren; ohne die eingeübten Kompetenzen und Arbeitsabläufe zu kannibalisieren.

Die Implementierung Künstlicher Intelligenz bringt Data Engineers, Datenwissenschaftler, IT, Fachbereiche und Management an einen Tisch.

Für die Einführung Künstlicher Intelligenz im organisatorischen Umfeld ist es nicht nur wichtig, technische Daten- und Informationssilos aufzubrechen. Es ist auch dringend notwendig, organisatorische Silos zu überwinden, um KI erfolgreich zu implementieren. Mit der Definition der notwendigen Komponenten und Analyse der bestehenden Prozesse fördern Sie die eigene, datengetriebene, bereichsübergreifende Denkweise und technische Weiterentwicklung. Wenn die einzelnen, notwendigen Backend-Komponenten richtig konfiguriert werden, kann die KI-Infrastruktur unendlich skalieren, mit dem Unternehmen mitwachsen und viele neue Synergieeffekte aufbringen. Trotz oder vielmehr wegen dieser strategisch weitreichenden Perspektiven bekommen KI-Projekte nicht selten eine nicht zu unterschätzende politische Ebene. Mehr Automatisierung und Transparenz bedarf empathisches Change Management im Unternehmen, um Vorbehalte und Ängste zu lindern, Vertrauen aufzubauen und die neuen Chancen und Risiken im Rahmen der Weiterentwicklung der gesamten Unternehmenskultur zu nutzen.

Die Unterstützung durch Künstliche Intelligenz setzt deren schrittweise Entwicklung und Implementierung anhand von spezifische Geschäftsprozessen voraus. Dies betrifft z.B.

- den Einsatz Künstlicher Intelligenz im E-Commerce,

- eine Optimierung von Onlineshops mit Hilfe Künstlicher Intelligenz,

- die Verbesserung von Produktempfehlungen,

- eine Vorhersage von relevanten Nutzereigenschaften,

- oder die Personalisierung von Content und UX.

Die Entscheidungsfindung von Künstlicher Intelligenz basiert auf höherer, mehrdimensionaler Statistik. Diese Algorithmen werden fortlaufend und mit großer wissenschaftlicher Expertise weiterentwickelt. Unternehmen, die Künstliche Intelligenz und bewährte Algorithmen einsetzten, sind Nutznießer dieses neuen, universitären Wettstreits.

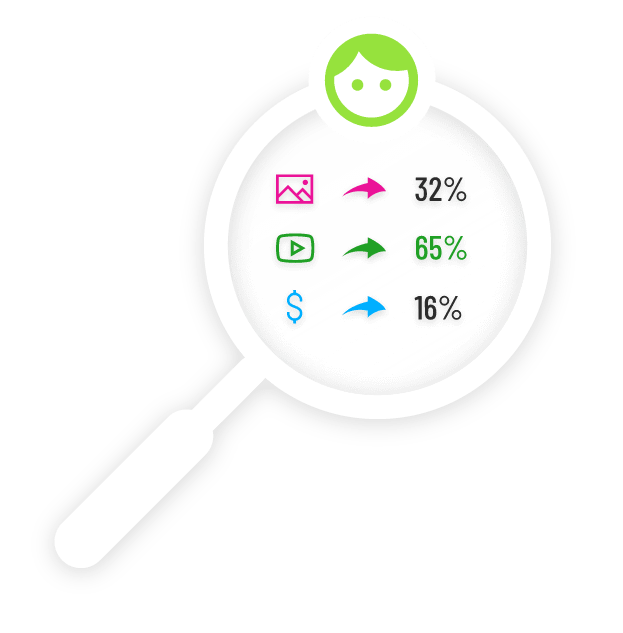

Neue Insights, Kontext Trends auf granularstem Datenlevel in Form von KI basierter Nutzersegmentierung.

Künstliche Intelligenz vereint unterschiedliche Teilgebiete.

Künstliche Intelligenz bündelt Data Mining, Big Data-Analytics, Data-Processing, Machine Learning und Anwendungsentwicklung. Es beginnt immer mit dem individuellen Datenraum und einzigartige Möglichkeiten eines Unternehmens.

Bevor eine KI-Anwendung Ihre Arbeit aufnimmt, müssen zunächst die richtigen Datenquellen angezapft und für die Weiterverarbeitung vorbereitet werden. Das ist die Aufgabe von Data Engineers. Danach modellieren Datenwissenschaftler den Use-Case und finden die passenden Algorithmen. Während es auf Data Science-Ebene in der Tiefe mit der Parameteroptimierung und Validierung der Outputs weitergeht, liegen die weiteren Aufgaben im Bereich der Software-Entwicklung. Hier geht es darum, die Algorithmen in der passenden Anwendung einzubetten. Es gilt, den KI-Output je nach Use Case „wirksam“ zu machen. Dies kann entweder über Schnittstellen an Drittsysteme oder über ein eigenes User Interface geschehen, um die Ergebnisse für den Anwender erfahrbar zu machen. Last but not least muss für die Automatisierung von Deployment, Data Pipelines und Trainingsprozessen gesorgt werden. Beginnt man Künstliche Intelligenz Projekte also „from the scratch“, sind die zu erwartenden Aufwände im Bereich Software-Entwicklung oftmals höher, als im Bereich Data Science.

Wie funktioniert Künstliche Intelligenz?

Unsere Teams finden in jedem Unternehmen eine neue Gemengelage aus gewachsenen Datenbankenstrukturen, Infrastrukturkomponenten und Informationsbedürfnissen vor. Diese müssen individuell behandelt werden. Künstliche Intelligenz gibt es derzeit nicht als Plug & Play-Lösung; schon gar nicht für multiple Anwendungsfälle. Die bestmögliche Integrationsstrategie berücksichtigt die vorhandenen Systemarchitekturen und Key Performance Indicators.

Egal ob Supply Chain Management, Content-Personalisierung oder die KI-gestützte Allokation von E-Mail-Anfragen. Die Herausforderung besteht darin die bestehenden Datenströme in eine kontinuierliche, zuverlässige Pipeline zu integrieren, daraus die notwendigen Informationen zu destilieren und den Informationsfluss eines ganzen Unternehmens mehrkriteriell zu optimieren.

Was ist eine schwache Künstliche Intelligenz?

Content-Personalisierung oder die Verbesserung von Produktempfehlungen sind konkrete Business-Herausforderungen und können von einer schwachen Künstlichen Intelligenz effizient gelöst werden. Die englische Übersetzung narrow AI ist dabei etwas treffender; schwache Künstliche Intelligenz ist in erster Linie eine KI, deren Fokus auf einen – zumeist: repetitiven – Prozess spezialisiert ist. Solche Prozesse sind z.B. im Bereich E-Commerce:

- Verbesserung von Produktempfehlungen,

- Vorhersage von relevanten Nutzereigenschaften,

- oder die Personalisierung von Content und UX.

Dabei ist zu bemerken, dass jeder dieser „einfachen“ Anwendungsbereiche im Hintergrund aus zig Modellen besteht, welche gemeinsam agieren. Schwache KI lässt sich hervorragend auf die Erkennung von Mustern oder die Automatisierung einzelner Entscheidungen (z.B. das Ausspielen der Next-Best-Action) spezialisieren. Die Echtzeitverarbeitung von tausenden Datenpunkten und deren Relationen ermöglicht den nächsten Evolutionsschritt von regelbasierten Wenn-Dann-Prozessen zu inhaltsbasierten, adaptiven Entscheidungensräumen.

Making YOUR world more predictable.

Wir begleiten Sie auf dem Weg ins KI-Zeitalter – als zuverlässiger Datenspezialist und Technologie-Partner.

Was ist eine starke Künstliche Intelligenz?

Eine starke Künstliche Intelligenz (eng. strong AI) wäre damit definitiv unterfordert. Eine Maschine mit umfassenden, intellektuellen Fähigkeiten – die ebenso flexibel lernt, adaptiert und reagiert wie ein Mensch – wäre eine starke Künstliche Intelligenz. Jene starke Künstliche Intelligenz würde nicht nur den Turing Test bestehen und die angesprochene Content-Personalisierung übernehmen, sie wäre auch in der Lage die Ausarbeitung und Realisierung von Marketingstrategien zu autonomisieren. Dieses Szenario ist derzeit unrealistisch und bleibt im Bereich der Science Fiction.

Was sind die Grenzen Künstlicher Intelligenz?

KI ist nur so gut, wie die Daten, mit der Sie diese trainieren. Für die Entwicklung von KI-Anwendungen, müssen Daten und Fragestellungen harmonisiert werden. Datenwissenschaftler brauchen Schnittstellen, die konsistente Daten liefert. Die hierfür notwendigen Aufgaben rund um das sog. Pre-Processing wie Datenbereinigung und Dimensionsreduktion sind nur bedingt automatisierbar und machen daher einen Großteil der Projektaufwände aus.

Aus diesem Grund werden immer mehr Software-Produkte auf Basis von sog. KI-Frameworks realisiert. Hierbei sind wichtige Komponenten, wie etwa Data Pre-Processing, Data Management und Trainingsroutinen, bereits optimal aufeinander abgestimmt. Diese KI-Frameworks lassen sich flexibel und kosteneffizient an jedes Kundensystem anbinden. Wie bei allen Frameworks in der Welt der Software muss jedoch immer auf Basis der individuellen Anforderungen entschieden werden, ob solch ein Framework zum Einsatz kommen soll. Unter anderem sollten hierbei Team-Kompetenzen, Technologie-Anforderungen auch hinsichtlich Flexiblität und Skalierbarkeit, die konkreten Anwendungsbereiche im Unternehmen, Risiken wie die Abhängigkeit von Dritten bei geschäftskritischen Prozessen, langfristige Kosten-Nutzen-Relation sowie Datenschutz aus strategischer Sicht gründlich evaluiert werden.

Let´s get it started!

Das Erkennen des Datenpotentials ist die Grundlage für jedes KI-Projekt. Wir bieten langjährige Erfahrung im Umgang mit Daten und KI-Modellen in unterschiedlichen Bereichen.

Für welche Geschäftsprozesse wird

Künstliche Intelligenz verwendet?

Die Verwendung von schwacher Künstlicher Intelligenz ist ein kosteneffizienter Einstieg für Unternehmen, da die erforderlichen Komponenten in einem KI-Framework zusammengefasst werden können. Solche Frameworks lassen sich flexibel an viele IT-Systeme anbinden und können skalierbar für einen reibungslosen Betrieb optimiert werden.

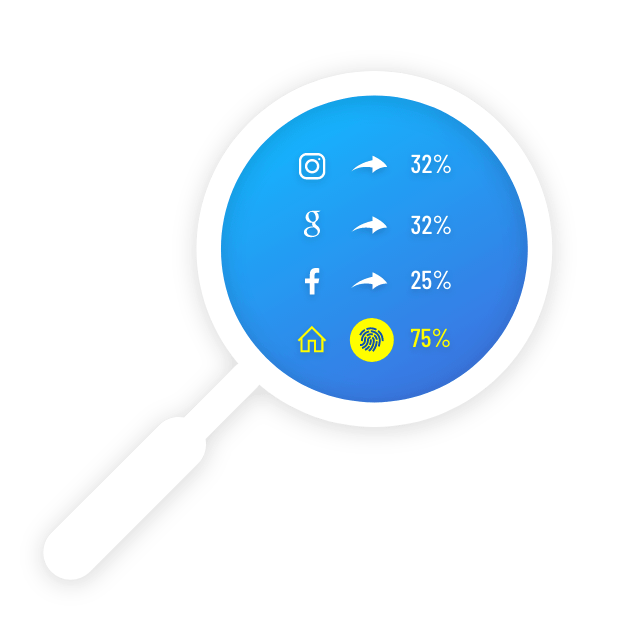

Zielgruppenansprache und Künstliche Intelligenz

Heute ist jede Marke online vertreten; ebenso wie die gesamte globale Konkurrenz jeder Marke. Aufgrund dieser gewachsenen Anbieterkonkurrenz scheint ein Angebotsüberhang zu existieren. Die neu entstandenen Käufermärkte sind vor allem durch eine schwindende Kundenloyalität gezeichnet. Aus diesem Grund streben Unternehmen nach einer optimalen User Experience und möchten den Wünschen ihrer Nutzer möglichst nahe kommen.

In diesem Fall werden KI-Anwendungen in Echtzeit mit Verhaltensdaten gefüttert. Mit Hilfe von Machine Learning und Approximationsmethoden erlernt Künstliche Intelligenz die relevanten Verhaltensweisen, Muster und Ontologien in diesem Datenstrom. Künstliche Intelligenz kennt für jeden Nutzer und zu jedem Zeitpunkt die Next-Best-Action auf Basis aller mathematisch relevanten Daten. Dabei kommt eine Mischung aus Kollaborativem Filtern und regelbasierter Personalisierung zum Einsatz

Mit Hilfe von Natural Language Processing (NLP) sind KI-Programme sogar in der Lage, Text- und Spracheingaben von Nutzer für die Analyse des Informationsinteresses zu Berücksichtigen. Der nächste Schritt: die Next-Best-Action mit einem personalisierten und optimierten Text zu ergänzen (Natural Language Generation, resp. NLG). Damit werden Werbetexte möglich, die besser konvertieren als menschlich geschriebene Texte – in Sekundenbruchteilen und einer unmenschlichen Größenordnung.

Risikoanalyse und Künstliche Intelligenz

Künstliche Intelligenz kann das Risiko, dass sich die Profitabilität einzelner Geschäftsprozesse verändert, anhand von tausenden Datenpunkten in Echtzeit abschätzen.

Absatzprognose und Künstliche Intelligenz

Künstliche Intelligenz verarbeitet sowohl quantitative Daten, also auch vermeintlich qualitative Daten. Die Nutzbarmachung von Emoji, Zero-Party-Data u.Ä. (tlw. mittels NLP / Sentimentanalyse) ermöglicht komplexe Vorhersagemodelle.

Retourenprävention und Künstliche Intelligenz

Der Mehrwert einer KI-gestützten Retourenprävention wird immer mehr E-Commerce-Spezialisten bewusst. Hohe Retourenquoten verursachen hohe Kosten. Eine Künstliche Intelligenz kann darauf trainiert werden, die Wahrscheinlichkeit einer Retoure während eines Kaufprozesses zu quantifizieren und aktiv über entsprechende Anpassungen der Interaktions- und Content-Angebote zu senken.

Informationsarchitektur und Künstliche Intelligenz

Wo sind Informationslücken, die meine Mitarbeiter in ihrer täglichen Arbeit behindern? Für die Analyse der Informationsarchitektur innerhalb eines Unternehmens liefert Künstliche Intelligenz das passende Besteck. Predictive Analytics und Natural Language Processing ermöglichen dafür die spannendsten Einblicke. Sie identifizieren nicht nur die verborgenen Rhythmen im eigenen Informationsfluss, sondern zeigen Ihnen auch, wann ein Kollege für welchen Informationsbruchteil und Detailtiefe der Information bereit ist.

Kommunikationsmanagement und Künstliche Intelligenz

Unternehmen sind jeden Tag mit einer großen Menge an Informationen konfrontiert. Um einem Information Overload proaktiv zu begegnen, kann die Verteilung von Kundenanfragen mit selbstlernenden KI-Assistenten optimiert werden.

Unser Angebot speziell für Digital Marketers

Verhaltensbasierte und kontextsensitive Echtzeit-Analysen in Online-Shops, Websites und Apps auf Basis komplexer, unstrukturierter Datensätze aus verschiedenen Datenquellen.

Was sind typische Algorithmen für den Einsatz Künstlicher Intelligenz?

Für Big Data-Analytics und Künstliche Intelligenz-Anwendungen stehen derzeit potentiell so viele Daten zur Verfügung, wie noch nie. Die Krux liegt in deren – ebenfalls historisch einmaligen – Fluidität. Die Wahl und Qualität des entsprechenden Algorithmus hängen von der Qualität der Daten, vom Ziel, dem Zeitrahmen und von den verfügbaren Ressourcen ab.

Egal ob DMEXCO, OMR oder Rise of AI – wir stoßen immer wieder auf dieselben Frage: Wie wichtig ist die Wahl des richtigen Algorithmus für die Wirksamkeit meiner Künstliche Intelligenz? Die Effizienz von KI wird durch das Zusammenspiel der Datenpipeline und der verbundenen Backend-Komponenten bestimmt. Die eingesetzten Algorithmen hingegen sind für die Transformation der Daten in Informationen verantwortlich. Die Effektivität von Künstlicher Intelligenz basiert maßgeblich auf dem korrekten Einsatz der richtigen Algorithmen.

Für jedes Projekt gibt es eine endliche Menge passender Algorithmen mit optimalen Parametern. Aus diesem Grund erweitern pflichtbewusste Machine Learning-Experten ihren Werkzeugkoffer fortwährend, denn neue Datensätze aus neuen Quellen erfordern eine stete Anpassung der Methoden und der Algorithmen. Hier kommen ein paar Beispiele für gängige KI-Algorithmen:

Decision Tree-Algorithmen

Sog. Entscheidungsbäume bilden eine Aufeinanderfolge von Entscheidungsregeln ab. Häufig kommen hierfür Baumdiagramme zum Einsatz. Mit Hilfe von formalen Regeln werden Datenobjekte entlang der Knoten und entsprechend ihrer Attribute schrittweise klassifiziert.

Beim Einsatz im Bereich des maschinellen Lernens werden Entscheidungsbäume induktiv aus Trainingsdatensätzen extrahiert. D.h. die Zuordnung der Trainingsobjekte ist bekannt und Algorithmen suche nach denjenigen Attributen und Knotenreihenfolge, welche die Trainingsdaten am besten abbilden.

Random Forest

Eine Vielzahl von Entscheidungsbäumen, die unterschiedliche Regeln und Spezifika verwenden, bilden einen Random Forest. In diesem Wald trifft jeder Baum eine unbeeinflusste, autarke Klassifikation bzgl. eines Datenobjekts. Diejenige Zuordnung, welche am häufigsten – d.h. von den meisten Bäumen – getroffen wurde, gewinnt.

Im Vergleich mit Klassifikationsverfahren wie der sog. Support Vector Machine lässt sich ein Random Forest schneller trainieren. Da die unterschiedlichen Bäume zudem gleichzeitig arbeiten, ist einen Parallelisierung der Berechnung möglich.

eXtreme Gradient Boosting

XGBoost ist ein Algorithmus, der auf maximale Effizienz in Bezug auf Rechenzeit und Speichernutzung getrimmt wurde. Zudem unterstützt er sowohl Regressions- als auch Klassifikationsprobleme. Gradient-Boosting ist ein Verfahren, welches das Ergebnis unterkomplexer Entscheidungsbäume kombiniert. Deren Fehlklassifizierungen lassen Schlussfolgerungen zu, anhand derer sich neue, stärkere Entscheidungsverfahren erstellen lassen.

Clusteranalysen mit k-Means-Algorithmen

Eine Gruppe von verwandten Datenpunkten wird in eine definierte Menge von k-Cluster untergliedert. Die Cluster haben in sich eine geringe Varianz und sind ähnlich groß. Dieser Algorithmus eignet sich hervorragend für umfangreiche Datenräume, da die Berechnung sehr effizient ist (= geringer Speicherbedarf).

Da k-Means homogene Cluster identifiziert, lassen sich damit z.B. das komplexe Rauschen einer Website in unterschiedliche Besuchersegmente differenzieren und Kundenansprachen gezielter aussteuern.

Neuronale Netze als Zusammenschluss von Algorithmen

Neuronale Netze bilden die Arbeitsweise menschlicher Informationsverarbeitung nach. Hierbei werden Informationen von sog. Neuronen gewichtet und mit Hilfe unterschiedlicher Algorithmen aggregiert. Diese Neuronen sind in Schichten angeordnet und diese Schichten wiederum sind untereinander verbunden.

Ein einfaches Neuronales Netzwerk besteht aus einem Input-Layer, dass die Daten / Vektoren aufnimmt, einem Hidden-Layer zur Datentransformationen und einem Output-Layer zur Ausgabe von Informationen. Derzeit werden mehrschichtige Neurale Netze (sog. Deep Learning) gehypt. In diesem Fall ist die Zahl der Hidden-Layer eines Künstlichen Neuronalen Netzwerks (KNN) größer als 1. Je mehr Zwischenschichten ein Deep Learning-Netzwerk hat, desto komplexere Probleme kann es lösen. Künstliche Neuronale Netzwerke können prinzipiell für jedes Optimierungsproblem eingesetzt werden: Vorhersage von Zeitreihen, Bild- und Spracherkennung oder auch Textgenerierung (Natural-Language Generation).

Die Spezifizierung von Deep Learning als spezielle Form von Künstlichen Neuronalen Netzen zeigt auch, dass diese Netzwerke kein eigenständiger Algorithmus sind; vielmehr sind Neuronale Netze eine bestimmte Form der Architektur von Algorithmen. Unter zur Hilfenahme von definierbaren Transformationsvorschriften (z.B. Weiterleitungs-, Aktivierungs- und Optimierungsfunktionen) werden die Ausgaben der Neuronen gewichtet und verknüpft. Indem ein Neuronales Netz dieselben Daten mehrmals verarbeitet, lernt es die eigenen Gewichtungen zu optimieren.

Making YOUR world more predictable.

Wir begleiten Sie auf dem Weg ins KI-Zeitalter – als zuverlässiger Datenspezialist und Technologie-Partner.

Was sind Methoden der Künstlichen Intelligenz?

Bei einer intensivieren Auseinandersetzung mit Künstlicher Intelligenz, werden Sie feststellen, dass deren Einsatz in Unternehmen durch Begriffe wie Algorithmus und Klassifizierer zwar hinreichend angedeutet wird; wenn Sie jedoch nicht wissen, mit welchen Methoden Künstliche Intelligenz arbeitet, dann wird es Ihnen vermutlich schwer fallen, die Lösungskompetenz Künstlicher Intelligenz richtig einschätzen zu können.

Optimierungsmethoden & Approximationsmethoden

Bei Big Data-Analytics geht es zuallererst um die Suche und Identifikation auffälliger und (möglicherweise) problematischer Anomalien innerhalb Ihres Datenuniversums. Maschinellem Lernen und Neuronale Netze arbeiten anschließend im Bottom-Up-Modus um die wiederkehrende Normalstruktur und scheinbare Unregelmäßigkeiten zu beschreiben. KI nutzt dazu sog. Approximationsmethoden um eine bestmögliche Modellierung des Datenraums anzulegen. Sie ist die Grundlage dafür, dass Künstliche Intelligenz-Anwendungen ein Optimierungsproblem (z.B. ein besonderes Nutzerverhalten) selbständig erkennen können.

Künstliche Intelligenz wird häufig zur Lösung von komplexen Optimierungsproblemen eingesetzt. Ein Optimierungsproblem setzt die Bewertung einer Abfolge von Daten als Abweichung von einem Idealfall voraus. Daten zeigen demnach an, dass sich ein Prozess anders vollzieht, als dies beabsichtigt ist. Eine typische Frage kann dann lauten: Wie steigern wir die CTR von einem Online Shop für Skate- & Streetwear?

Wie funktioniert die Integration von Künstlicher Intelligenz ins eigene Unternehmen?

Typischerweise setzt sich ein Daten-Team (Dateningenieuren, Datenwissenschaftlern, Business-Analysten) mit Bereichsleitern und allen verbunden Fachbereichen an einen Tisch. Gemeinsam skizzieren sie die notwendigen Bausteine, Verantwortlichkeiten und Kennzahlen zur Erfolgsmessung. Dabei berücksichtigen sie die unternehmensspezifischen Datenströme, Prozesse und Informationsarchitekturen.

Die Implementierung Künstlicher Intelligenz funktioniert am Besten im MVP-Modus (MVP = Minimum Viable Product). Die Entwicklung von KI-Anwendungen wird dann mit einem Minimum an eigenen Ressourcen realisiert, um einen ersten POC (Proof-of-concept) zu entwickeln. Zu hohe Komplexitäten sollte man dabei vermeiden. Für den ersten Schritt ist das Sammeln erster wichtiger Erfahrungen des Teams auf den Daten wichtig und ein zu frühes „verkomplizieren“ des Use Cases sollte vermieden werden. Der Business Impact sollte im Fokus liegen, wobei ein schnelles Scheitern und nachjustieren wichtig sein kann, um Ressourcen zu sparen. Gedanken über technische Nachhaltigkeit bei der Entwicklung können (und müssen) später folgen. Gleichzeitig ist eine valide Einschätzung des unternehmensspezifischen Big Data-Potentials möglich, was für die iterative Weiterentwicklung viele neue Perspektiven mitbringt.